深度|AI Agent部署应在效率与人本之间找到平衡

当企业把“能否智能自动化”这个问题回答为“能”之后,接下来真正困难的却往往是“如何把智能自动化做得既高效又有人情”。技术容易被复制,组织的信任与文化则难以重建。以人为中心的 AI Agent 部署,不只是把工具丢给业务线那么简单,它要求在设计、治理、培训与文化上做出同步调整,才能把效率提升与员工成长同时实现。

在这个过程中,市场上的若干解决方案提供了技术路径与产品实践。本文探讨如何把AI Agent当作“人的放大器而非替代者”来部署。

一、从“替代”到“增强”:重新定义成功指标

把AI Agent当成替代工具,会很自然地把目标定为“替代多少人力、节省多少成本”。这种单维度的衡量,很容易把关注点局限于短期效率数字,忽略长期组织能力的构建。以人为中心的思路要求企业在衡量成功时把“人的价值”也作为重要指标:包括员工的满意度、判断力是否得到了提升、工作中是否有更多时间用于创造性任务。

产品层面上,这意味着设计要支持“人机共治”而不是“机器独裁”。比如,一个能被一线员工理解的决策快照、一个明确的人工覆盖按钮,或者把人工反馈直接转化为规则更新的闭环——这些机制比单纯的“自动执行”更能带来长期信任。

二、设计三原则:可解释、可控、可撤回

要让人放心与 Agent 合作,产品设计需满足三个底层属性。

可解释性并非学术模型指标,而是以业务可读方式呈现信息。合格的 AI Agent 要能回答建议依据及依赖数据,这对一线员工决策很重要。实践中,很多部署在决策界面嵌入“证据链”,助人工快速判断。

可控性是在权限与风险边界上明确设计。要基于风险分级制定放权策略,如低风险格式校验可直接执行、中等风险流程建议先确认、高风险或合规场景需集中审批,实现方式包括分级权限等。

可撤回性强调操作事务边界与回退能力。自动化非“单向”,发现问题要及时回滚或补救,企业常以“回退时间窗”为安全阈值,确保可无损撤回错误操作。

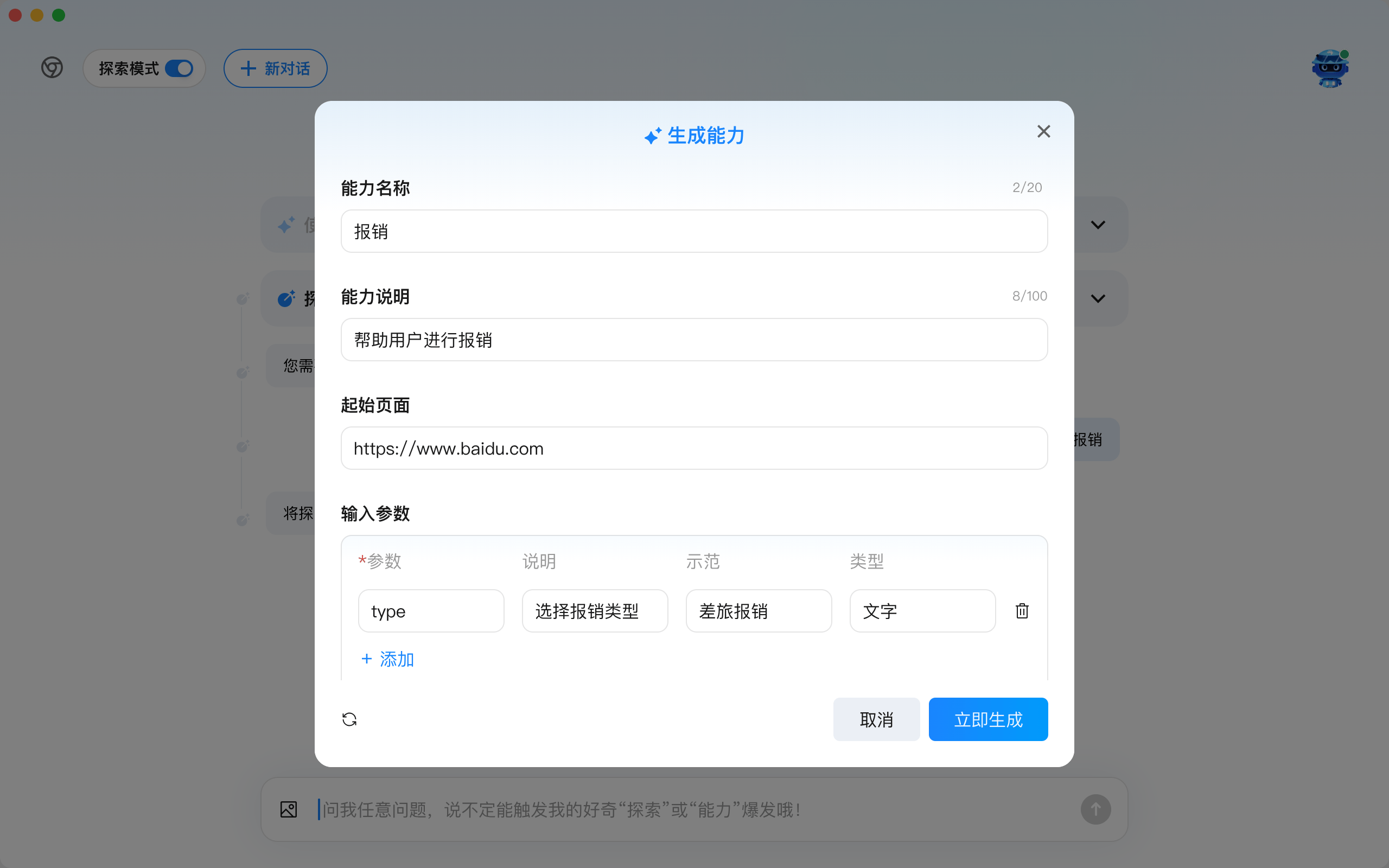

九科信息bit-Agent的核心能力

这些原则既是产品设计指引,也是组织制定治理规则的基础。九科信息的bit-Agent就强调把“执行证据+回退接口”作为默认能力,从而让业务方在试点早期即有把控感。

三、试点策略:从建议者到执行者的渐进式路径

实践中,稳妥的部署路径通常从“建议者”角色开始,再逐步向“执行者”开放。第一步常为影子运行或并行验证,让 Agent 与人工同时运行,对比结果。期间需收集人工反馈、统计误判分布、评估业务可接受的自动通过率。

当建议准确率达业务可接受阈值,采用“半自动化”策略,即 Agent 自动完成常规步骤,关键节点人工确认。随着信任建立,放宽阈值,允许更多自动执行。这种渐进式路径有两个好处:降低一次性出错的冲击,让组织在放权中形成治理与培训流程。

值得注意,试点成功不仅取决于算法性能,更取决于流程设计与反馈闭环质量。产品若能让业务人员将人工决策“转成”系统策略,可将单次人为判断转化为组织可复用的能力包。如此,工具不仅是执行器,更是长期能力沉淀的平台。

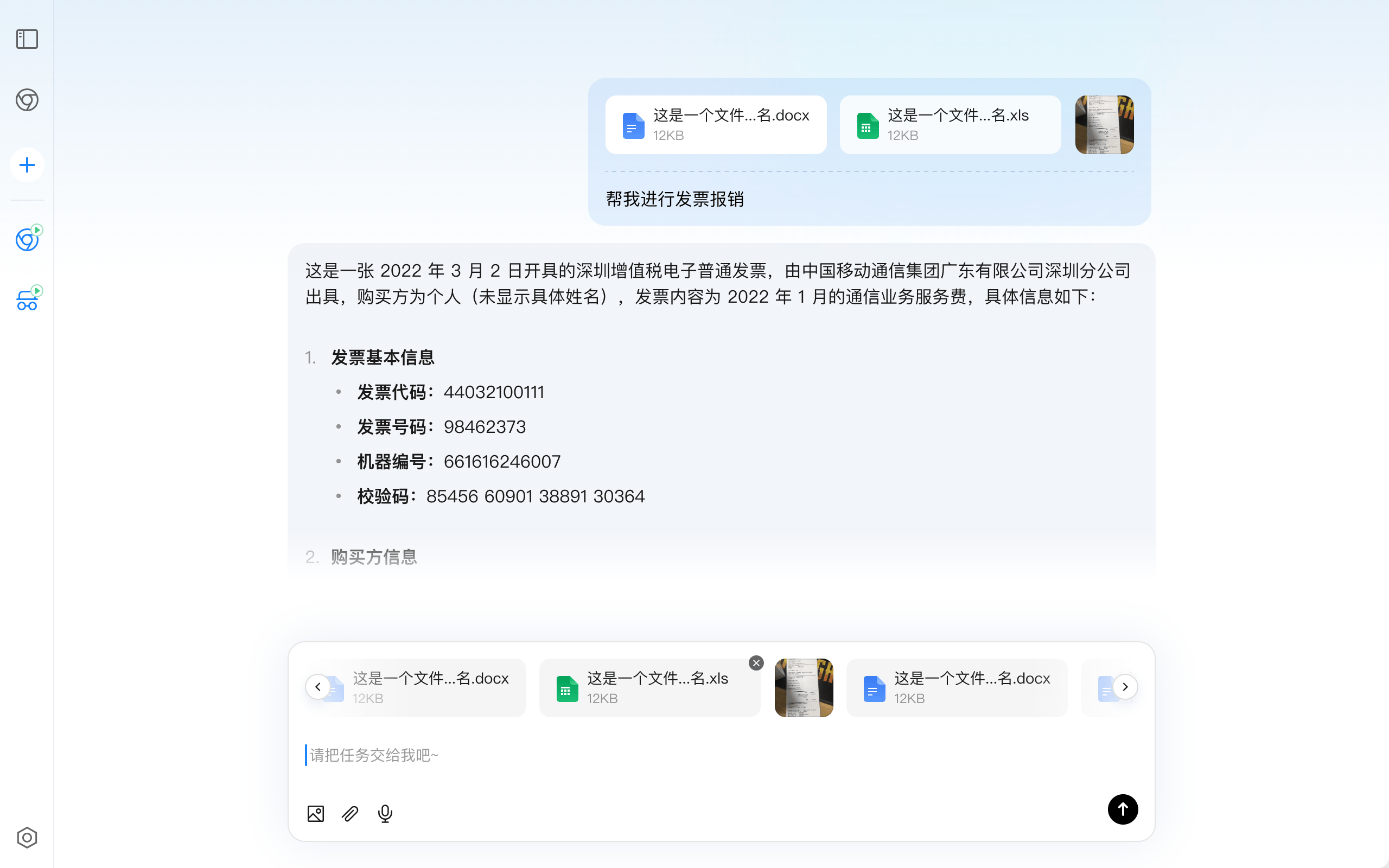

九科信息bit-Agent的“能力固化”功能

九科信息的 bit-Agent 首次完成某类型任务后,会将流程固化为“能力”或模板。系统记录操作序列、触发条件、关键证据及人工干预点,打包成可版本化、可审批的能力单元。经业务或合规侧审核后,该能力发布到组织能力库供调用。此固化机制一方面缩短后续类似任务开发与执行时间,另一方面减少对大模型的频繁调用,在稳定性、响应延迟与成本上实现优化。同时,能力的版本管理与回退机制确保组织在环境变化或发现问题时能快速回溯迭代,保证“能力沉淀”可复用且可治理。

四、治理与监控:把“可观测性”作为第一要务

治理并非束缚创新,而是为其提供可持续护栏。引入AI Agent到业务后,组织需建立可观测监控体系,不仅监控系统可用性,更要监控决策质量。常见监控指标有自动通过率、人工干预率、误报原因分布、平均回退时间等,这些指标既能告知管理层放量节奏,也可作为模型或规则迭代的触发条件。

九科信息bit-Agent执行流程可视化

此外,审批链与责任矩阵要在项目启动前明确。谁有权批准某条规则上线?谁负责放权决策?谁在出现问题时负责回滚?把这些责任事先写入流程,可以在出现偏差时迅速定位与处置。技术上要确保每一次自动执行都产生“决策快照”并归档,便于事后审计与复盘。

产品层面的支持会显著降低治理成本:例如内置的审计日志、决策回放、版本管理与策略审批工作流,能让业务与合规双方在同一平台上协作。

五、文化与能力建设:把反馈当作组织的燃料

技术再好也需要人来推动。以人为中心意味着把员工的反馈、学习与成长嵌入日常运维。实践上,企业可以把“人工干预”看作一种输入,而非失败:每次人工修复都是系统的训练样本。把这些样本系统化、结构化并回流给产品或模型团队,才是真正把“个体经验”转化为“组织能力”的路径。

同时,要有明确的培养路径:教会员工如何阅读决策快照、如何判定建议的合理性、如何把人工修复规范化为规则。

六、风险侧写:漂移、偏差与制度性盲区

任何把判断自动化的尝试都要面对偏差与漂移的问题:数据集不完备会导致偏见,环境变化会触发生态漂移,规则外的新场景会让系统暂停。解决之道并非找一个万能模型,而是制定多层防线:严谨的数据治理、持续的性能验证、以及快速的回退机制。

此外,要警惕制度性盲区:例如,过度依赖自动化决策可能导致员工判断力退化,长期则会降低组织对突发状况的应变能力;又如把合规边界外包给自动化系统,可能会在法律风险上留下隐患。治理策略需要把这些长期风险纳入考量,推动制度、培训与技术同步演进。

七、展望:把 Agent 变成人的放大器而非替身

面向未来,有竞争力的组织会把AI Agent当作“人的放大器”,将重复性工作自动化,解放判断资源,让人从事高阶创造、策略与服务。企业要实现这一点,需三方面持续投入:一是将产品能力(可解释、可控、可回退)作为基建;二是常态化开展治理、监控与审批;三是将培养人与组织学习能力作为长期工程。

在此过程中,技术供应方与企业应成为长期合作者,产品要满足功能需求,还需在治理、培训与能力固化上提供实践支持。像九科信息的bit - Agent这类面向企业级落地的产品,注重可观测性与能力沉淀,为以人为中心推进智能化的企业提供可参考的落地路径。

真正的胜利是构建“人 + Agent”协作体系,使组织能更快学习、稳健决策、富有创造力。将此目标作为部署AI Agent的北极星,才能平衡效率与人本。